Het belang van betekenisvolle menselijke controle (want ook AI-systemen hebben last van vooroordelen)

Nu computers steeds slimmer worden, kunnen ze steeds meer taken overnemen van de mens. Daarbij zijn ze steeds beter in staat om onafhankelijk beslissingen te nemen. Grote vraag: hoe zorgen wij mensen ervoor dat we betekenisvolle controle houden?

AI als onderdrukker? Zo ver is het nog niet. Maar wereldwijd zijn er al veel landen met politieteams die bij opsporingswerk experimenteren met voorspellende algoritmen. In september 2020 publiceerde Amnesty International daar een alarmerend rapport over. De conclusie: buiten het zicht van de mens om bleken die AI-systemen discriminerend te handelen.

Zo objectief mogelijke voorspelling

Voor een computer is het dus nog lastig om menselijke vooroordelen uit de beschikbare data te filteren. En dat is een groot probleem. Want als iemand op basis van een AI-voorspelling als mogelijke verdachte wordt aangemerkt, moet dat op een zo objectief mogelijke manier gebeuren. En niet op basis van een vooroordeel.

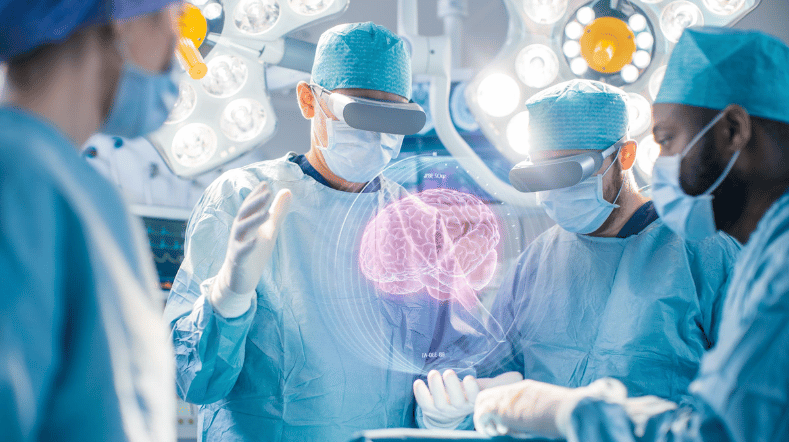

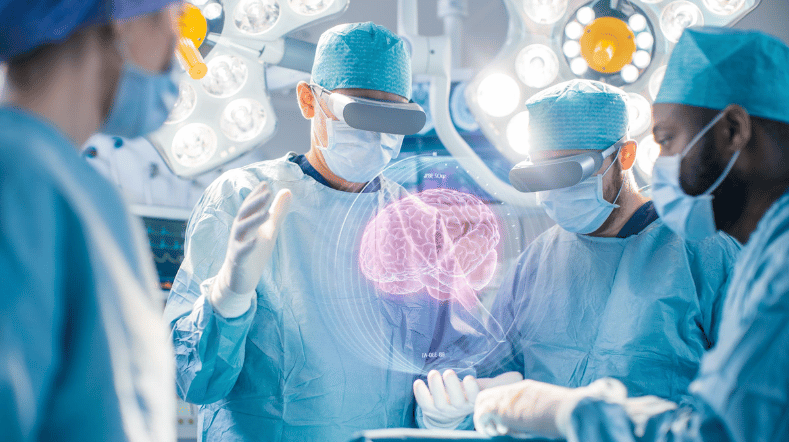

AI-systemen als teampartners

De oplossing? Teams samenstellen waarbij AI-systemen partners zijn van mensen. Bij kritieke besluiten blijft de mens op die manier betrokken en in controle. Die interactie tussen mensen en AI is essentieel om systemen te ontwikkelen die op een ethische manier kunnen handelen op basis van voorspellingen.

Daarbij kunnen mensen de capaciteiten van geavanceerde AI optimaal benutten door zoveel mogelijk taken op abstract niveau te delegeren. Ondertussen hebben ze altijd de mogelijkheid om bij te sturen. Tegelijkertijd moeten AI-systemen zichzelf kunnen uitleggen en de mens actief bij het data-analyseproces betrekken. Op die manier kunnen we voorkomen dat een AI conclusies trekt op basis van onbetrouwbare data of verkeerde aannames.

Meer aandacht voor mens-robot interactie

Er is dus een laag van ‘sociale AI’ nodig. Samen met de Nederlandse Defensie, NATO en universiteiten heeft TNO op dat vlak al een aantal veelbelovende stappen gezet. Zo is er nu een eerste prototype van een delegatiesysteem, dat al wordt ingezet bij interacties tussen mensen en robots. Ook hebben we een test waarmee we (in een laboratoriumsetting) de mate van menselijke controle kunnen meten.

Eindverantwoordelijkheid bij de mens

Het doel? Ervoor zorgen dat mensen op een verantwoorde wijze taken aan AI-systemen kunnen toevertrouwen. Zonder daarbij de controle te verliezen. De eindverantwoordelijkheid blijft dus bij de mens liggen.

Er zijn momenteel veel domeinen waar mensen op zo’n controleerbaar AI-systeem zitten te wachten. Bij de politie en defensie bijvoorbeeld. Of bij de logistiek en zorg. Ook daar zitten ze te springen om een AI-systeem dat werk uit handen neemt op betrouwbare wijze en zonder vooroordelen.

Neem contact met ons op

Laat je verder inspireren

Nederland gaat voor AI-fabriek

TNO Unboxed #1 | GPT-NL: het Nederlandse taalmodel

Werken aan betrouwbare AI

AI-systeem voor persoonlijk advies gezonde leefstijl

Nieuw consortium ontwikkelt geavanceerde AI voor bewakingsrobots